هوش مصنوعی گوگل عکسهای شما را زیرنویس میکند

نسبت به دو سال گذشته، این یک پیشرفت بزرگ است، در آن زمان دقت آن الگوریتم در طبقهبندی تصاویر ۸۹٫۶ درصد بود. توصیفات بهتر برای تصاویر میتواند به شکلهای مختلفی برای تاریخنگاران، افراد نابینا یا کمبینا و البته محققان هوش مصنوعی مفید باشد.

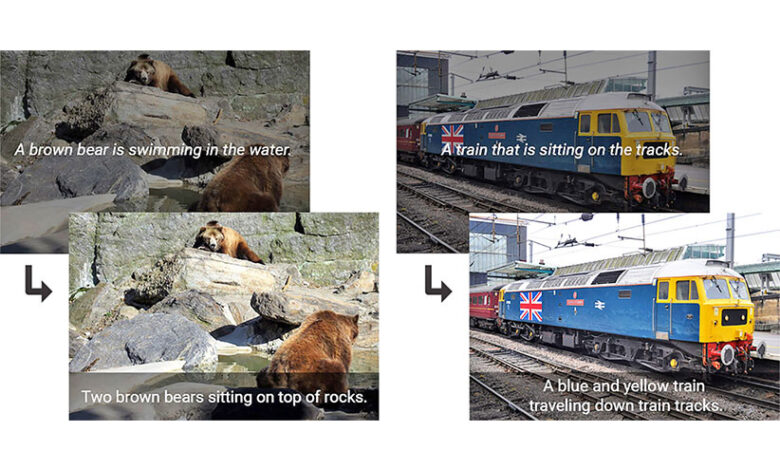

این الگوریتم متن باز گوگل از نسل سوم مدل Inception و یک سیستم بینایی جدید استفاده میکند و در تشخیص اشیای مختلف بهتر عمل میکند. محققان همچنین آن را برای دقت بیشتر بهینهسازی کردند. تیم Google Brain نوشته: «به عنوان مثال، مدل طبقهبندی تصاویر به شما میگوید که یک سگ، چمن و فریزبی در عکس وجود دارد، اما یک توصیف طبیعی درباره رنگ چمن و واکنش سگ به فریزبی هم اطلاعاتی میدهد.» نسل سوم مدل Inception نه تنها اشیا را در تصویر تشخیص میدهد بلکه رابطه بین آنها را هم میفهمد.

محققان با استفاده از زیرنویسهای تصویری انساننوشته سیستمشان را آموزش دادند. سپس این سیستم می توانست تصاویری را توصیف کند که قبلا ندیده بود. به عنوان مثال، این سیستم با استفاده از چندین تصویر سگ در ساحل، توانست زیرنویسهایی برای منظرههای مشابه اما کمی متفاوت تولید کند.

گوگل کد منبع این الگوریتم را برای روی سیستم TensorFlow منتشر کرده است تا هر کسی که علاقهمند باشد از آن استفاده کند.

منبع:digikala

No tags for this post.