شبکه های عصبی عمیق (DNN) می توانند درباره همه چیز آموزش ببینند. با این حال مشکل اساسی در این زمینه این است که تعلیم دادن به سیستم های هوش مصنوعی به استفاده بسیار زیاد از ابررایانه ها یا دیتاسنترها مرتبط می شود. محققان مرکز تحقیقاتی IBM بر این باروند که می توان با استفاده از "واحد های پردازش مقاومتی" انرژی و زمان مورد نیاز برای آموزش این سیستم ها را کاهش داد.

این تراشه ها می توانند اطلاعات را با سرعت پردازش کرده و انتقال دهند که همین امر نیز خود زمان و انرژی لازم برای آموزش به هوش های مصنوعی را تا حد زیادی کاهش می دهد.

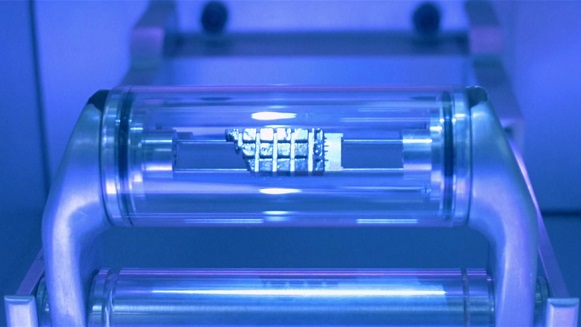

باید بدانید که واحد های پردازش مقاومتی تراشه هایی هستند که پردازنده و حافظه غیر فرار را با یکدیگر ترکیب می کنند ولی هنوز در مرحله نظری قرار دارند. این تراشه ها می توانند سرعت انتقال داده را به صورت تصاعدی بالا برده و در نتیجه این امر هوش های مصنوعی می توانند وظایفی نظیر شناسایی گفتار طبیعی و ترجمه هم زمان میان زبان های مختلف را به راحتی انجام دهند.

به این ترتیب سوالی که مطرح می شود این است که چرا آموزش به هوش های مصنوعی انرژی و زمان زیادی را به خود اختصاص می دهد؟ مشکل اینجاست که سیستم های عصبی مدرن مانند هوش مصنوعی جدید کمپانی گوگل به نام ذهن عمیق (DeepMind) یا هوش مصنوعی جدید IBM به نام واتسون (Watson) باید چندین وظیفه مختلف را به طور همزمان انجام دهند که این امر خود نیازمند برقراری ارتباطات بسیار زیاد و سریع میان حافظه و پردازنده است. به این ترتیب محققان به تازگی ایده ساخت تراشه هایی را مطرح کرده اند که مقدار زیادی از حافظه پردازشی یا RAM را مستقیما در درون پردازنده قرار می دهد.

این تراشه ها می توانند اطلاعات را با سرعت پردازش کرده و انتقال دهند که همین امر نیز خود زمان و انرژی لازم برای آموزش به هوش های مصنوعی را تا حد زیادی کاهش می دهد. باید به یاد داشت که ساخت این تراشه ها هنوز در مراحل اولیه و آزمایشی قرار دارد و تکنولوژی به کار رفته در آن ها در ابتدا صرف مصارف تجاری خواهد شد. با این حال ساخت تراشه هایی با حافظه محلی بسیار سریع ایده ای منطقی برای افزایش سرعت وظایف انجام شده توسط هوش های مصنوعی است.

منبع: engadget

ترجمه: آناهیتا عیوض خانی

No tags for this post.