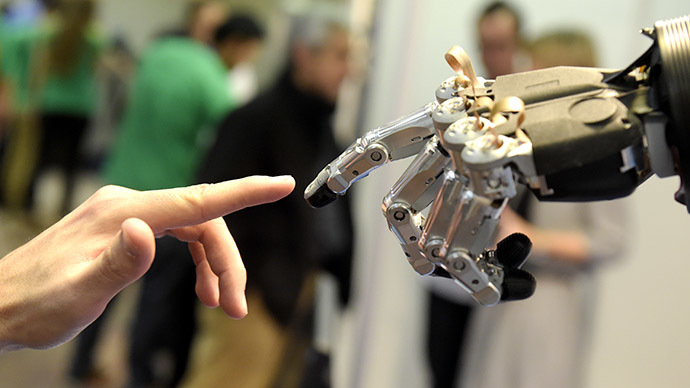

نبرد با هوش مصنوعی آغاز شده است

به تازگی تیمی از پژوهشگران مرکز پژوهش های بریتانیا طی مقاله ای اعلام کردند که قوانین و آئین نامه های فعلی به میزان کافی قادر به محدود کردن اقداماتی که می تواند توسط هوش مصنوعی صورت گیرد، نبوده و خواستار تعیین قوانینی شدند که برای روبات ها نیز به اندازه انسان های سازنده آن ها مسئولیت ایجاد کند. به گفته پژوهشگران، موارد متعددی در این زمینه وجود دارند که به طور بالقوه می توانند مشکل ساز شده و خطراتی برای بشر ایجاد کنند. مواردی از قبیل جمله ماهیت متنوع سیستم های در حال توسعه و عدم شفافیت در مورد فعالیت های درونی هوش مصنوعی از این جمله هستند. در این گزارش به طور واضحی تاکید شده است که: «سیستم های هوش مصنوعی می توانند تصمیماتی ناعادلانه و تبعیض آمیز گرفته و با دارا بودن تمایلات خاص و جانبدارانه، رفتارهای مرموز و غیر منتظره ای در مناطق حساس از خود نشان دهد که منافع و امنیت بشریت را به خطر خواهد انداخت. »

مرموز بودن، تنوع بسیار زیاد و نفوذ ناپذیری هوش مصنوعی سبب پیچیده شدن روند تدوین قوانین این حوزه می شود که امری سهل و ممتنع به شمار می رود که در ظاهر ساده ولی در عمل بسیار دشوار است.

به بیان دیگر برای بسیاری از کارشناسان این سوال مطرح است که ما چگونه می توانیم به هوش مصنوعی اعتماد کنیم؟ حتی پیش از رسیدن به مرحله فعلی که شاهد حضور روبات ها در عرصه های مختلفی هستیم، بسیاری از موارد مرتبط با هوش مصنوعی، غیر قابل فهم و تفسیر هستند. دلیل تصادف خودروهای بدون راننده که توسط هوش مصنوعی هدایت می شوند یا رد شدن بی دلیل درخواست وام بانکی شما توسط کامپیوتر بانک نمونه هایی برای اثبات این نظریه به شمار می روند. موضوع خطرناک دیگر در این مورد، افزایش سیستم های مبتنی بر هوش مصنوعی است که در ارتباط با قوانین عمل کرده و نظارت چندانی بر آن ها وجود ندارد.

در این میان برخی از پژوهشگران پیشنهاداتی در رابطه با این موضوع اعلام کرده اند که از آن میان می توان به ایده جمع آوری و ارائه مجموعه ای از دستورالعمل های مرتبط با هوش مصنوعی، فعالیت های روباتیک و الگوریتم های مرتبط با آن ها اشاره کرد که البته محققان اذعان دارند به دلیل کثرت و تنوع حوزه های مربوط به این موضوع، ارائه یک دستورالعمل کلی در این رابطه کار دشواری محسوب می شود.

از سوی دیگر گروهی از کارشناسان نیز اعتقاد دارند شفافیت و ارائه تمامی اطلاعات مرتبط با این حوزه می تواند تاثیراتی منفی بر عملکرد سیستم های هوش مصنوعی گذاشته و به احتمال قوی شرکت های پیشرو در این زمینه تمایل چندانی به افشا شدن رازها و فناوری های مخفی خود و دسترسی رقبا به این اطلاعات ندارند.

در این گزارش عنوان شده است: «مرموز بودن، تنوع بسیار زیاد و نفوذ ناپذیری هوش مصنوعی سبب پیچیده شدن روند تدوین قوانین این حوزه می شود که امری سهل و ممتنع به شمار می رود که در ظاهر ساده ولی در عمل بسیار دشوار است. »

این برای نخستین بار نیست که سه پژوهشگر مطرح فوق در زمینه هوش مصنوعی یعنی آندرا واچر (andra Wachter)؛ برنت میتلزتاد (Brent Mittelstadt) و لوسیانو فلوریدی (Luciano Floridi) نسبت به این موضوع هشدار می دهند. آن ها در ماه ژانویه سال جاری نیز خواهان وضع قوانین حمایتی در رابطه با هوش مصنوعی از سوی اتحادیه اروپا شده بودند.

هوش مصنوعی می تواند به خدمت بشر در بیاید

لوسیانو فلوریدی از پژوهشگران و اساتید دانشگاه آکسفورد در این رابطه می گوید:«ما در حال حاضر بیش از حد وابسطه به الگوریتم هایی هستیم که به ما اجازه طرح سوال در این زمینه را می دهد.» وی و شاگردانش در همین رابطه پرونده ای قضائی بر علیه دولت های اتریش و آلمان مطرح کرده اند که در آن عنوان شده است این کشورها به مردم خود اطلاعات کافی درباره این موضوع که الگوریتم های فوق چگونه در تصمیم گیری مردم تاثیر دارد؛ ارائه نمی کنند.

البته به این موضوع نیز باید توجه داشت که هوش مصنوعی می تواند در خدمت بشریت نیز قرار گرفته و به افراد مختلفی کمک کند. برای نمونه افراد کهنسال می توانند به کمک این فناوری به صورت مستقل زندگی کرده؛ استفاده از خودروهای بدون راننده به همه مردم اجازه داشتن خودرو داده و یا شناسائی نشانه های بیماری توسط هوش مصنوعی پیش از پزشکان می تواند به بیماران کمک کند.

در حال حاضر دانشمندان در تلاش هستند تا اقدامات لازم در زمینه کنترل و پیش بینی اقدامات ایمنی در شرایط خاص و زمانی که هوش مصنوعی از کنترل خارج شد؛ را اتخاذ کرده و شرایط تسلط بشر بر هوش مصنوعی را افزایش دهند.

شرح کامل این مقاله در محله تخصصی علوم روباتیک یا Science Robotics منتشر شده و در اختیار پژوهشگران قرار دارد.

منبع: sciencealert

ترجمه: احسان محمدحسینی

No tags for this post.